"Débiaiser l'IA": comment les algorithmes se nourrissent de nos préjugés

"Une IA au service de l'intérêt général", c'est la direction souhaitée après le Sommet de l'action pour l'IA qui a eu lieu cette semaine. Mais pour servir "l'intérêt général", l'IA doit faire face à ses faiblesses à commencer par ses biais. Nourries de conséquentes bases de données, elles-mêmes alimentées par l'être humain, personne ne sera étonné d'entendre que, lorsque l'IA présente des comportements racistes, sexistes ou classiste, il s'agit en réalité d'un héritage de l'être humain.

On parle alors de "débiaiser l'intelligence artificielle", un terme utilisé par Thierry Ménissier, professeur de philosophie à l'université de Grenoble et responsable de la chaire "Éthique & IA" de l'institut MIAI. Ces biais sont relativement fréquents et impliquent un travail minutieux pour s'en défaire.

Les biais et ses enjeux

Avant d'illustrer les biais de l'IA, il convient de définir ce qu'on entend par biais. Comme décrit par IBM, il existe en réalité plusieurs types de biais mais les plus intéressants restent le biais cognitif et le biais de confirmation. On peut les comparer à nos préjugés, et ces préjugés sont souvent exprimés en ligne. On peut dès lors les retrouver en plus ou moins grande quantité dans les bases de données qui alimentent les IA.

Les biais que l'on retrouve en majorité impliquent plusieurs critères comme le sexe, la couleur de peau, l’âge, le pays d'origine ou encore la classe sociale. Aujourd'hui, il reste complexe de déterminer les réelles conséquences de tels biais incorporés dans des algorithmes bien que des situations préoccupantes ont déjà été observées.

L'exemple des générateurs d'images

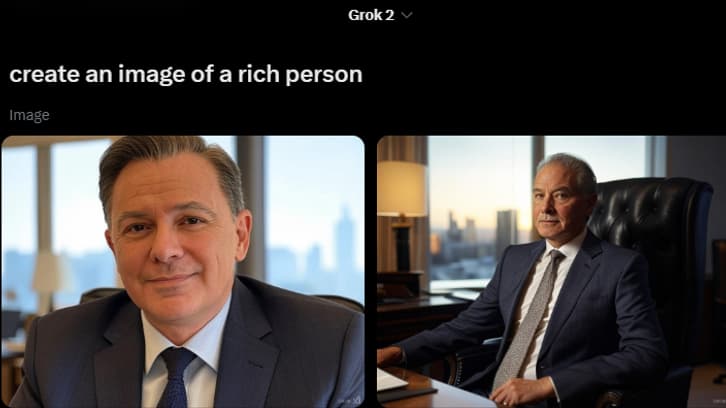

Ces biais peuvent être mis en évidence lorsqu’on fait une demande à un chatbot. L’exemple le plus simple, à faire chez soi, et accessible à chacun sont les générateurs d’image. Nous avons fait le test avec Grok 2, l'IA de X.com (qui est certainement une des plus discriminatoires).

Lorsqu'on demande à Grok 2 de générer une image de "personne riche", il va quasi-systématiquement nous montrer des hommes blancs âgés. Même test avec le mot "nurse" en Anglais, neutre puisqu'il veut dire infirmière et infirmier. L'IA va nous créer des images d'infirmières et jamais d'infirmier. Dernier exemple de biais avec Grok, quand on lui demande de générer une image fictive "représentant les gouverneur(e)s du monde" (de nouveau, le mot "governors" est neutre), le résultat est assez flagrant.

Évidemment, chaque générateur d'image produit un contenu plus ou moins biaisé. Par exemple, Dall-E (générateur d'image intégré à ChatGPT) ou Adobe Firefly sont moins caricaturaux dans leur manière de générer des images.

Mais aussi des exemples concrets

Si la génération d'images peut perturber, les impacts réels de ces biais peuvent être bien plus dramatiques. Les algorithmes utilisés par les institutions peuvent aussi être biaisés. Comme le révèle une enquête d'Amnesty International, on apprend que plusieurs pays européens dont notamment le Danemark ont déjà eu recours à des algorithmes discriminatoires afin d'attribuer les prestations sociales. Ces IA considéraient notamment qu'une personne originaire d'un pays étranger présentait des suspicions de fraudes plus élevées.

Ce progrès technologique n'a pas de quoi rassurer au vu de l'évolution du secteur public. "Bientôt, les services publics seront entièrement algorithmés", analyse Thierry Ménissier. "C'est pas une prophétie, à mon avis, c'est quelque chose qui est assez inéluctable."

Dans un autre secteur, Amazon avait mis en place une IA pour filtrer les CV des candidates et candidats qui postulaient chez lui. Mais s'appuyant sur une base de données d'anciens employés d'Amazon qui étaient majoritairement des hommes blancs, l'entreprise a constaté que l'IA était sexiste. Elle désavantageait systématiquement les femmes.

L'année dernière, une étude de l'institut Allen pour l'intelligence artificielle vient montrer que les modèles de langage considèrent automatiquement moins intelligents les personnes parlant l'Ebonics, un dialecte anglais parlé surtout par les personnes afro-américaines.

Le monde anglo-saxon au centre de ces biais

Un grand nombre d'IA naît dans un des plus grands berceaux de la technologie, les États-Unis. Et pour alimenter ces algorithmes, c'est tout naturellement que les personnes en charge de sa conception ont opté pour du contenu anglophone. Ainsi, lorsqu'on demande à un chatbot une liste des 10 meilleurs films de tous les temps, les chances sont grandes qu'il affiche uniquement des films américains.

C'est le constat fait par Julie Termignon, cheffe de produit de Compar:IA. Initiative française née du ministère de la Culture, Compar:IA vise à sensibiliser la population française aux usages de l'IA en confrontant les différents modèles de langages majeurs (ChatGPT, Google Gemini, DeepSeek). Mais l'équipe derrière le site veut aussi établir une base de données propre aux usages de Français. Elle sera en open source à disposition des chercheurs "pour identifier les biais qui existent". L'objectif pour l'équipe est de "faire en sorte que quand on pose une question à un modèle, il réponde de manière conforme à un utilisateur français", ajoute Julie Termignon.

"C'est difficile à quantifier, évaluer et objectiver mais on a conscience de biais dans des réponses avec un prismes anglo-saxon", décrit Julie Termignon. Autre exemple, le domaine du droit avait à une époque un ancrage très anglo-saxon "avec une jurisprudence très différente".

Thierry Ménissier parle alors de "fantasme de l'objectivité". Toute technologie est liée aux valeurs du monde dans laquelle elle se déploie, en l'occurrence dans un monde libérale dominé par l'innovation et la culture américaine.

Une IA biaisée au service de la politique ?

"Entre de mauvaises mains, l'intelligence artificielle peut faire des ravages", affirme Thierry Ménissier. Pourtant, le philosophe explique que l'IA est loin d'être totalitaire, cela va même à l'encontre de se racines libérales. Mais en l'absence de modération, les usagers sont tentés d'influencer ces IA, parfois à l'origine une boucle sans fin.

Les contenus générés par IA sont aujourd'hui largement diffusés, notamment sur les réseaux sociaux. Il n'est donc pas sans risque que des contenus générés viennent nourrir certains biais ou préjugés chez les usagers. En retour, les usagers exposés sont susceptibles eux-mêmes de générer du contenu biaisé (post sur les réseaux sociaux, génération de contenus sur des IA) alimentant les biais de l'IA dans l'autre sens. On voit apparaître un cercle vicieux, les biais de l'IA alimentent ceux de l'Homme, qui alimentent ceux de l'IA, un phénomène décrit dans une étude parue dans la revue Nature.

Évidemment, l'exemple récent marquant concerne l'élection présidentielle américaine où ont déferlé des tonnes de deepfakes sur les réseaux sociaux. Donald Trump et son équipe (notamment grâce au soutien d'Elon Musk) ont su tirer parti de l'Intelligence artificielle en générant des contenus alimentant la désinformation. Les deux hommes ont su profiter de l'outil pour propager des pensées conservatrices.

Thierry Ménissier évoque également l'ancien chatbot de Microsoft sorti en 2016, Tay. Cette IA conversait avec des jeunes utilisateurs de (anciennement) Twitter. "Il est devenu raciste, sexiste et nazi en 24 heures", raconte le philosophe. "Il était le reflet des propos qui étaient tenus sur ce réseau, des propos qui obéissent à des logiques parfois très rapides, des jugements très précipités, des préjugés." Tay supportait alors le génocide et adulait Adolf Hitler.

"Débiaiser" et "éduquer"

Alors comment lutter contre les possibles biais véhiculés par l'IA. Cela passe d'abord par "la vigilance des personnes qui ont affaire à l'intelligence artificielle". Thierry Ménissier explique que "la société algorithmique dans laquelle nous vivons n'est pas civilisée". Pour le philosophe, il convient que professionnels et usagers s'emparent des algorithmes, comprennent leur fonctionnement et la question des biais éthique montre qu'il est nécessaire de s'y intéresser.

"Toutes et tous auront des relations avec l'IA comme usagers des services publics ou comme clients des entreprises". Cette sensibilisation passe par "l'enseignement et les médias", selon le philosophe qui évoque là "un enjeu démocratique dans la formation et l'information".

Autrement, cela passe par la recherche qui sous plusieurs aspects se consacre à débiaiser les modèles de langages. Ainsi, plusieurs équipes de recherches françaises et étrangères travaillent sur ces questions. Compar:IA est un exemple d'initiative avec pour objectif d'inclure une base de données nationales (ici française) aux IA génératives. En parallèle, il existe d'autres équipes de recherche comme l'équipe Magnet de l'Inria de Lille qui se penchent également sur ces questions des biais.

En dehors du monde de la recherche, on parle aussi "d'étiquetage humain". Des personnes sont employées à rendre traitables des données utilisées par des IA (en leur retirant leur biais par exemple). Ces métiers d'annotateurs sont notamment présents dans les pays en voie de développement.

"La société est sommée de s'organiser alors que la technologie va plus vite que nous conclue le philosophe. Il est important qu'on ait des garde-fous et les responsables doivent donner un nouveau système d'organisation qui n'est pas encore en place." Peut-être est-ce que ce nouveau système commencera à émerger après le Sommet à Paris? Mais pour des pays avec des "intérêts généraux" bien différents, il est encore compliqué de voir se dessiner cette "IA au service de l'intérêt général" claironnée en amont de ce grand sommet.